Индексация сайта: механика процесса и практические методы управления

Страницы, которые поисковики не индексировали, не появятся в выдаче, даже если контент качественный. Разбираем, как устроена индексация в Google и Яндексе и какими инструментами можно её контролировать и ускорять.

9 декабря 2025

Время чтения: 7 минут

Индексация — это процесс, при котором поисковые роботы проходят по сайту, анализируют содержимое страниц и добавляют их в свою базу данных. Без этого этапа даже полезный контент останется невидимым в поиске.

В этой статье разберём, как работают краулеры Google и Яндекса, какие факторы ускоряют или замедляют индексацию, и как использовать инструменты вебмастеров для контроля процесса. Информация полезна владельцам сайтов и маркетологам, которые хотят обеспечить попадание новых страниц в поиск.

Как работают поисковые роботы при индексации

Поисковые системы используют специальные программы — краулеры (Googlebot для Google, YandexBot для Яндекса), которые переходят по ссылкам и собирают информацию о страницах. Процесс начинается с известных документов, откуда роботы следуют по внутренним и внешним ссылкам, постепенно обнаруживая новые разделы сайта. Частота сканирования зависит от авторитетности домена, скорости загрузки страниц и регулярности обновления контента.

Системы применяют алгоритмы для определения приоритетности обхода — активно обновляемые ресурсы с качественным контентом посещаются чаще. Google обновляет базу ежедневно, Яндекс проводит переобход несколько раз в неделю. После сканирования документов происходит обработку данных: извлечение текста, анализ метатегов, оценка семантической релевантности запросам пользователей.

Многие владельцы сайтов ошибочно считают, что достаточно просто создать страницу, и она автоматически попадет в поиск. На практике роботы могут не найти документ месяцами, если к нему нет ссылок с уже проиндексированных страниц или он заблокирован в robots.txt. Проверяйте доступность новых разделов через Яндекс.Вебмастер и Google Search Console сразу после публикации.

— Алексей Ефимов, руководитель SEO «Ефремов Медиа»

Различия индексации в Яндексе и Google

Яндекс более чувствителен к действиям пользователей на сайте — время на странице, глубина просмотра, возвраты в выдачу влияют на позиции сильнее, чем в Google.

Факторы, влияющие на скорость попадания в индекс

Google делает упор на техническую надежность: наличие HTTPS-протокола, корректную работу на мобильных устройствах, отсутствие ошибок в структурированных данных. Для российского рынка оптимальная стратегия — балансировать требования обеих систем, но приоритет выбирать исходя из того, где находится основная целевая аудитория проекта.

Технические характеристики сайта играют значительную роль — ошибки 404, некорректный HTML-код, дублирование мета-тегов замедляют обработку страниц поисковиками. Отсутствие HTTPS-протокола снижает доверие систем к ресурсу, особенно для страниц с формами сбора данных. Мобильная адаптивность стала обязательным требованием после перехода Google на mobile-first индексацию — версия для смартфонов анализируется в первую очередь.

Внутренняя перелинковка определяет, насколько быстро роботы обнаружат новые разделы. Страницы, на которые нет ссылок с других документов сайта, попадают в «тупиковую зону» и считаются менее значимыми. Особенно эффективны ссылки с главной страницы и самых посещаемых разделов — они передают больший вес и ускоряют индексацию в разы.

Видел десятки случаев, когда владельцы интернет-магазинов жаловались на отсутствие товарных страниц в индексе. При проверке выяснялось, что к новым позициям можно было попасть только через 4-5 уровней вложенности каталога. Решение простое: добавьте блок 'Новинки' на главную с прямыми ссылками на свежие товары. Индексация ускоряется с недель до суток.

— Алексей Ефимов, руководитель SEO «Ефремов Медиа»

Настройка файлов robots.txt и sitemap.xml

Файл robots.txt размещается в корневом каталоге сайта и управляет доступом поисковых роботов к разделам ресурса. Директива User-agent определяет, для какого бота применяются правила, Disallow запрещает индексацию указанных путей, Allow создает исключения из запретов. Обязательно добавьте строку Sitemap с полным URL карты сайта — это помогает роботам быстрее найти все важные страницы.

Типичные ошибки в robots.txt блокируют индексацию целых разделов. Если в файле присутствует строка вида «SetEnvIfNoCase User-Agent ^Googlebot search_bot», это полностью запрещает доступ ботам Google. Аналогичные директивы существуют для YandexBot. Проверить корректность настроек можно через инструменты в Google Search Console и Яндекс.Вебмастере — они показывают, какие страницы заблокированы от сканирования.

Карта сайта sitemap.xml содержит список всех документов для индексации с дополнительными данными. Атрибут lastmod указывает дату последнего изменения и помогает роботам понять, когда обновлять индекс. Параметр priority задает приоритет страницы от 0.0 до 1.0, но поисковики используют его только как рекомендацию. Для крупных сайтов создавайте отдельные карты для разных типов контента — статьи, товары, категории — и объединяйте их в индексный sitemap.

Статическая карта сайта предпочтительнее динамической, которая генерируется при каждом запросе. Динамическое создание sitemap.xml занимает время и снижает скорость загрузки, что негативно влияет на краулинговый бюджет. Настройте автоматическое обновление статической карты с заданной периодичностью — ежедневно для новостных сайтов, еженедельно для корпоративных порталов, при добавлении товаров для интернет-магазинов.

Способы проверить индексацию страниц

Операторы поисковых систем позволяют быстро узнать статус документов в индексе. Запрос «site:ваш-домен.ru» в строке поиска Google или Яндекса покажет все проиндексированные страницы ресурса. Для проверки конкретного URL используйте полный адрес с оператором «site:» — если страница найдена, она присутствует в базе данных поисковика.

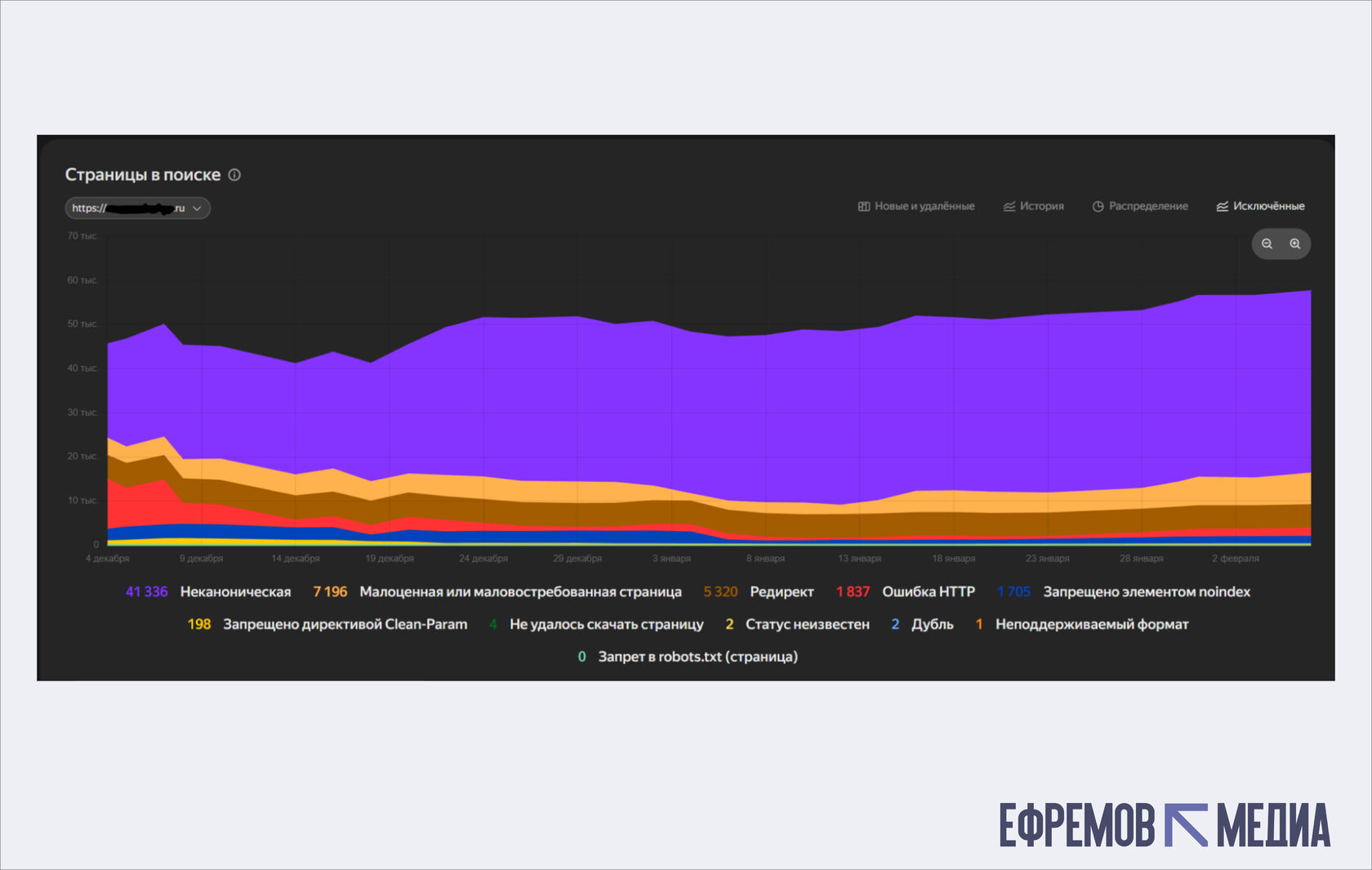

Яндекс.Вебмастер предоставляет детальную информацию в разделе «Индексирование». Инструмент «Страницы в поиске» показывает количество документов в индексе, историю изменений, причины исключения страниц. Вкладка «Проблемы» содержит список ошибок, препятствующих индексации — дублирующиеся title, медленная загрузка, проблемы с robots.txt.

Блок «Проблемы» содержит полный список препятствий индексации с индикаторами критичности: от технических ошибок до дублирования контента и медленной загрузки

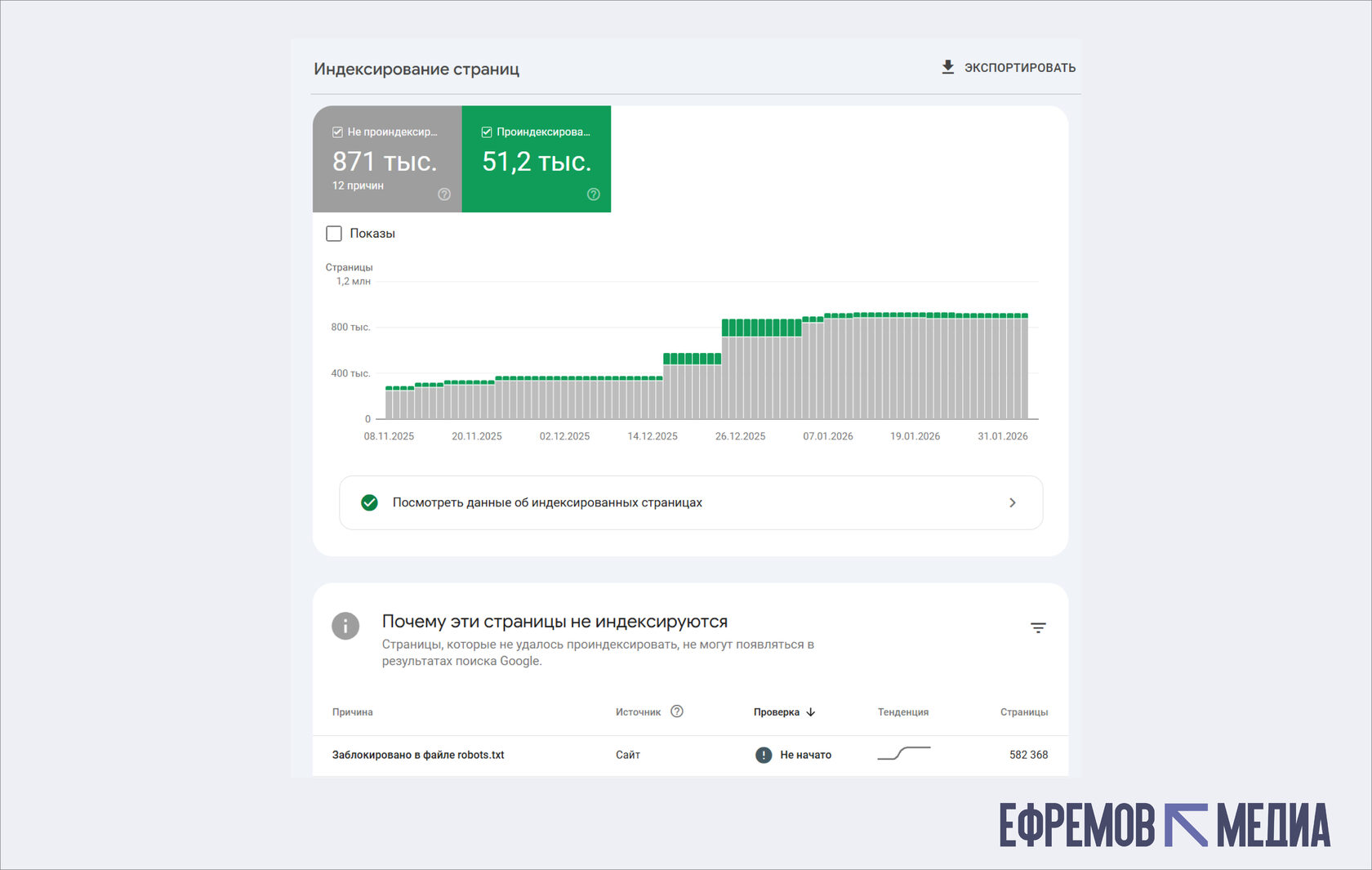

Google Search Console отображает статус индексации в разделе «Покрытие». Отчет разделен на категории: проиндексированные страницы, исключенные, с ошибками, с предупреждениями. Инструмент «Проверка URL» позволяет узнать, может ли Google получить доступ к конкретной странице, увидеть ее так, как видит робот, запросить повторное сканирование.

Раздел «Покрытие» отображает полную картину статуса индексации: сколько страниц успешно проиндексировано, сколько имеют ошибки, сколько исключено

Сторонние сервисы автоматизируют мониторинг индексации больших объемов страниц. Rush Analytics, Arsenkin.ru и аналогичные инструменты проверяют списки URL одновременно, предоставляют данные о дате первой индексации, ссылки на сохраненные копии, возможность экспорта результатов в CSV. Настройте регулярные проверки — ежедневные для критичных разделов, еженедельные для стабильных проектов, ежемесячные для информационных ресурсов.

Как ускорить индексацию новых страниц

Инструмент «Переобход страниц» в Яндекс.Вебмастере отправляет запрос на повторное сканирование конкретных URL. После публикации новых материалов добавьте их адреса в этот раздел — обработка начнется в течение нескольких часов. Лимит запросов зависит от авторитетности сайта, для новых проектов доступно 10-20 URL в сутки, для зрелых ресурсов квота увеличивается.

В Google Search Console аналогичная функция находится в инструменте «Проверка URL». Введите адрес новой страницы, нажмите «Запросить индексирование» — Google добавит документ в очередь на сканирование. Приоритет обработки выше для сайтов с хорошей историей, регулярными обновлениями и отсутствием технических проблем.

Размещение ссылок на новые страницы в уже проиндексированных разделах — надежный способ ускорить обнаружение контента. Добавьте блоки «Последние публикации», «Новинки», «Рекомендуем» на главную страницу и в популярные разделы. Анонсируйте материалы в социальных сетях, телеграм-каналах, тематических сообществах — внешние переходы сигнализируют поисковикам о появлении интересного контента.

Пинг-сервисы автоматически уведомляют поисковые системы об обновлениях на сайте. Многие CMS имеют встроенные модули для отправки уведомлений при публикации новых записей. Для WordPress плагины вроде All in One SEO или Yoast SEO автоматически пингуют поисковики и обновляют sitemap.xml. Этот метод работает как дополнение к основным способам, но не заменяет правильную настройку файлов и структуры сайта.

Клиенты часто просят ускорить индексацию тысяч товаров одновременно. Поисковики распределяют краулинговый бюджет постепенно, попытка форсировать процесс через массовые запросы переобхода приводит к обратному эффекту. Оптимальная тактика — приоритизировать самые важные страницы, отправлять на индексацию небольшими партиями, остальное пусть система обработает естественным образом при правильно настроенном sitemap, robots.txt, метатегах и структуре сайта.

— Алексей Ефимов, руководитель SEO «Ефремов Медиа»

Почему страницы не попадают в индекс

Метатег noindex блокирует индексацию. Запрет в метатеге noindex или атрибуте robots блокирует добавление документа в поисковую выдачу. Проверьте исходный код страницы — если в секции head присутствует <meta name=«robots» content=«noindex»>, поисковики не будут индексировать этот URL. Аналогичный эффект дает HTTP-заголовок X-Robots-Tag со значением noindex.

Дублирование контента приводит к потере видимости. Дублирование контента заставляет поисковые системы выбирать одну версию страницы в ущерб остальным. Проблема возникает при доступности сайта по нескольким адресам (с www и без, http и https), наличии параметров сортировки и фильтров в URL, копировании текстов с других ресурсов. Используйте 301 редирект для объединения дублей, канонический тег rel=«canonical» для указания основной версии, закрывайте служебные страницы через robots.txt.

Технические ошибки сервера препятствуют сканированию. Технические ошибки сервера препятствуют сканированию документов роботами. Код ответа 404 сообщает об отсутствии страницы, 500 указывает на внутреннюю ошибку сервера, оба варианта приводят к исключению из индекса. Медленная загрузка страниц (более 3 секунд) может прерывать процесс индексации — поисковики не тратят ресурсы на обработку медленных сайтов.

Низкое качество контента снижает приоритет индексации. Низкое качество контента снижает шансы попадания в индекс даже при отсутствии технических проблем. Страницы с тонким контентом (менее 300 символов полезного текста), высокой плотностью ключевых слов (переспам), автоматически сгенерированными текстами исключаются алгоритмами. Яндекс и Google стремятся показывать пользователям релевантные и полезные материалы, поэтому документы без ценности для аудитории не получают приоритета в обработке.

Мониторинг и поддержание индексации

Регулярный аудит выявляет проблемы на ранней стадии. Регулярный аудит индексации выявляет проблемы до того, как они повлияют на трафик. Настройте еженедельные отчеты в Google Search Console и Яндекс.Вебмастере — уведомления приходят на электронную почту при обнаружении критических ошибок. Следите за динамикой проиндексированных страниц — резкое снижение количества документов сигнализирует о технических проблемах или санкциях.

Обновление контента ускоряет переобход страниц. Обновление контента на существующих страницах поддерживает их актуальность в глазах поисковых систем. Дополняйте статьи новой информацией, актуализируйте устаревшие данные, обновляйте дату публикации в lastmod карты сайта. Роботы чаще посещают ресурсы с регулярными изменениями, что ускоряет индексацию обновленных материалов.

Логи сервера показывают поведение краулеров. Анализ логов сервера показывает реальную картину поведения поисковых ботов на сайте. Изучайте, какие разделы роботы посещают чаще, где застревают, сколько времени тратят на обход. Данные помогают оптимизировать краулинговый бюджет — закрыть от индексации малозначимые страницы, улучшить доступность важного контента.

Структурированные данные помогают попадать в расширенные сниппеты. Структурированные данные Schema.org облегчают поисковикам понимание контента страниц. Разметка товаров, статей, FAQ, рейтингов передает системам дополнительную информацию о документах, что повышает вероятность попадания в расширенные сниппеты. Проверяйте корректность микроразметки через валидаторы Google и Яндекса — ошибки в структурированных данных могут привести к исключению страниц из специальных блоков выдачи.

Инженерные детали процесса индексации

Краулинговый бюджет определяет, сколько страниц поисковая система готова сканировать на сайте за определенный период. Параметр зависит от авторитетности домена, скорости ответа сервера, качества контента. Для небольших сайтов (до 1000 страниц) бюджет обычно избыточен, но крупные порталы сталкиваются с ограничениями — роботы не успевают обойти все документы.

Инкрементальная индексация позволяет поисковикам обновлять информацию о странице без полного пересканирования. Системы запоминают предыдущее состояние документа, при повторном посещении анализируют только изменения. Механизм экономит ресурсы и ускоряет обработку обновлений на больших сайтах.

Рендеринг JavaScript-контента требует дополнительных ресурсов от поисковых систем. Google обрабатывает динамический контент через отложенный рендеринг — сначала индексирует статический HTML, затем возвращается для выполнения скриптов. Яндекс справляется с JavaScript хуже, для важных элементов предпочтительна серверная отрисовка или предварительный рендеринг.

Сегментация индекса разделяет документы по категориям свежести и качества. Страницы попадают в основной индекс (часто обновляемый, высокое качество), дополнительный (редкие обновления, средняя релевантность) или удаляются из базы данных. Продвижение между сегментами происходит постепенно при улучшении показателей контента и поведенческих факторов.

Кэширование страниц сохраняет снимок документа на серверах поисковой системы. Пользователи могут просмотреть сохраненную копию, даже если оригинал недоступен. Дата кэша показывает, когда робот последний раз посещал страницу — информация полезна для определения частоты переобхода конкретных разделов.

FAQ

Сколько времени занимает индексация новой страницы?

В Google 1–3 дня при активном запросе через Search Console. В Яндексе 3–7 дней при подаче через Вебмастер. Сроки зависят от авторитетности сайта, наличия ссылок на новую страницу и отсутствия технических проблем. Страницы на зрелых доменах индексируются быстрее.

Как проверить, проиндексирована ли страница?

Используйте оператор поиска site:ваш-домен.ru/нужная-страница в Google или Яндексе. Если страница найдена, она в индексе. Для детальной информации откройте Google Search Console или Яндекс.Вебмастер и посмотрите статус в разделе «Покрытие» или «Индексирование».

Почему страница не индексируется, если техническая часть в порядке?

Проверьте, нет ли метатега noindex, редиректов или блокировки в robots.txt. Убедитесь, что контент достаточно объёмный (минимум 300 символов полезного текста). Если на страницу нет ссылок с других документов сайта, роботы могут долго её не находить — добавьте ссылку с главной или популярного раздела.

Какой краулинговый бюджет у моего сайта?

Поисковики не раскрывают точные цифры. Для сайтов до 1000 страниц бюджета обычно хватает на все документы. Для крупных портальных проектов оптимизируйте структуру: удалите малозначимые страницы из индексации, улучшите перелинковку важных разделов, ускорьте загрузку.

Как ускорить индексацию товарных страниц в интернет-магазине?

Добавьте новые товары блоком на главную страницу с прямыми ссылками. Используйте инструмент «Переобход страниц» в Яндекс.Вебмастере и «Проверка URL» в Google Search Console. Убедитесь, что sitemap.xml содержит все товарные страницы и обновляется при добавлении товаров.

Влияет ли robots.txt на SEO?

Да, но косвенно. Robots.txt не передает информацию о релевантности, но контролирует доступ краулеров к страницам. Неправильные настройки могут полностью заблокировать индексацию важного контента. Проверяйте robots.txt через Google Search Console или Яндекс.Вебмастер.

В чём разница между Google и Яндексом в индексации?

Google делает упор на техническую надежность и экспертность (E-E-A-T). Яндекс более чувствителен к поведенческим факторам (время на странице, возвраты в выдачу) и региональной привязке. Google обновляет индекс ежедневно, Яндекс несколько раз в неделю. Оптимальная стратегия — балансировать требования обеих систем.

Нужно ли обновлять sitemap.xml при каждом изменении?

Для статических сайтов обновляйте sitemap еженедельно. Для динамических проектов (новости, блоги) — ежедневно. Для интернет-магазинов обновляйте при добавлении товаров. Используйте автоматическое обновление через CMS или специальные плагины.

Свежие статьи